Endişeler büyüyor: Hindistan, Facebook ve YouTube'u açık açık tehdit etti!

Hindistan hükümeti Facebook ve YouTube'u deepfake videolarıyla oluşturulan sahteciliğe karşı kuralları uygulaması için uyardı. Hükümet ayrıca aksi takdirde onları bunu yapmaya zorlayan talimatlar vereceğini söyledi.

Hindistan hükümeti, Cuma günü Facebook ve YouTube gibi sosyal medya şirketlerini, yerel yasaların kullanıcılara müstehcenlik ya da yanlış bilgi yayan içerikler ve deepfake'ler yayınlamalarını yasakladığını tekrar tekrar hatırlatmaları konusunda uyardı.

Uyarı, Bilişim Bakan Yardımcısı Rajeev Chandrasekhar tarafından kapalı bir toplantıda iletildi ve Chandrasekhar, çocuklara "zararlı", müstehcen veya "başka bir kişiyi taklit eden" içeriği yasaklayan 2022 kurallarına rağmen birçok şirketin kullanım koşullarını güncellemediğini söyledi.

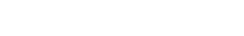

DEEPFAKE'LERLE İLGİLİ ENDİŞELER ARTIYOR

Bu karar, üst düzey bir bakanın bu hafta Hindistan'ın ele almak üzere kurallar hazırladığını söylediği, çevrimiçi görüntüler üzerinde eğitilen yapay zeka (AI) algoritmaları tarafından oluşturulan gerçekçi ancak uydurma videolar olan deepfake'lerle ilgili artan endişelerin ortasında geldi.

Hollywood yıldızına Deepfake şoku: Hayranlarını Instagram üzerinden uyardı!

Hollywood yıldızına Deepfake şoku: Hayranlarını Instagram üzerinden uyardı!

Chandrasekhar, şirketlerin kullanıcılara her giriş yaptıklarında bu tür içerikleri yayınlayamayacaklarını hatırlatarak ya da hatırlatıcılar yayınlayarak kurallar konusunda farkındalık oluşturmaları gerektiğini söyledi.

HİNDİSTAN FACEBOOK VE YOUTUBE'U AÇIK AÇIK TEHDİT ETTİ

Reuters'in aktardığı bilgilere göre, görüşme özel olduğu için isimlerini vermek istemeyen iki kaynak, aksi takdirde onları bunu yapmaya zorlayan talimatlar vereceğini söyledi.

Kaynaklardan biri, bakanın toplantı sırasında bunu Hindistan hükümetinin "müzakere edilemez" bir talebi olarak tanımladığını söyledi.

Hindistan BT bakanlığı yaptığı basın açıklamasında tüm platformların içerik yönergelerini hükümet kurallarıyla uyumlu hale getirmeyi kabul ettiğini söyledi.

Google'ın yaptığı açıklamada, sorumlu yapay zeka geliştirme konusunda kararlı olduğunu ve ürün ve platformlarında zararlı içeriği tespit edip kaldırmak için sağlam politika ve sistemlere sahip olduğunu söyledi.

TOPLUMUN ÜZERİNDEKİ OLUMSUZ ETKİLERİNE DEĞİNİLDİ

Hindistan hükümeti ve Başbakan Narendra Modi son günlerde deepfake'lerle ilgili endişelerini dile getirdi.

Bu kareler ABD'yi ayağa kaldırdı: Milyonlarca kez görüntülendi!

Bu kareler ABD'yi ayağa kaldırdı: Milyonlarca kez görüntülendi!

Çarşamba günü G20 ülkelerinin sanal zirvesi sırasında Başbakan Modi, küresel liderleri yapay zekayı düzenlemek için ortaklaşa çalışmaya çağırdı ve deepfake'lerin toplum üzerindeki olumsuz etkilerine ilişkin endişelerini dile getirdi.

Dünyanın dört bir yanındaki ülkeler yapay zekayı düzenlemek için kurallar koymakta yarışıyor. Hindistan, Güney Asya ülkesini en büyük büyüme pazarı olarak gören sosyal medya şirketlerine yönelik düzenlemeleri sıkılaştırıyor.

Geçen yıl hükümet, şirketleri sitelerindeki sahte haber olarak nitelendirdiği haberleri kaldırmadıkları için özel olarak eleştirmiş ve bunun da kendisini içerik kaldırma emri vermek zorunda bıraktığını söylemişti.